Versuch einer (Teil-)Antwort auf „Why Ambiguity?“ von Ariel Cohen

Zusammenfassung von Cohens Frage:

In einem der „40 to 60 puzzles for Krifka“ stellt Ariel Cohen die Frage, warum es in allen Sprachen der Welt Amibguität gibt. Und tatsächlich, wie Cohen auch richtig bemerkt, gibt es kaum einen Satz in einer Sprache, der nicht ambig ist. Auch kommt er zu dem Schluss, dass Menschen zwar über Mechanismen verfügen Amibguitäten aufzulösen, dies aber nicht erklärt, warum es in allen Sprachen der Welt Ambiguität gibt. Weiter denkt er darüber nach, ob die Ambiguität der Sprachen vielleicht auf deren Komplexität her rührt und führt an, dass etwa Programmiersprachen dazu entwickelt wurden nicht-ambig zu sein.

Bemerkenswert ist auch seine sprachökomische Argumentation hinsichtlich Hörer und Sprecher. Während es für den Hörer ideal wäre, würde es keine Ambiguitäten geben, da so weniger Missverständnisse auftreten würden, wäre es für den Sprecher von Vorteil, wenn seine Sprache maximal ambig wäre, „so that one word would mean everything.“ Sein Beispiel kid, das sowohl child, als auch young goat bedeuten kann, zeigt allerdings, dass, obwohl es im Englischen ein Wort gibt, das beides bedeuten kann, das Wort child nicht einfach verschwindet. Das bedeutet, dass Ambiguität nicht dazu führt, dass es weniger Ausdrücke in einer Sprache gibt, sondern im Gegenteil mehr. „Quite the contrary, in fact: languages tend to be redundant, i.e. use several expressions to express the same meaning.“

Cohen fasst seine Frage so zusammen: „We seem to be forced to the conclusion that there is some pressure on languages to be ambigous: there is some advantage to using an ambigous language.“

Überlegungen zu einer (Teil-)Antwort:

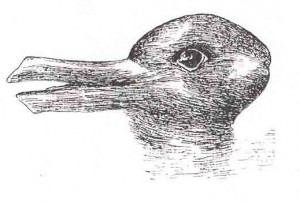

Zunächst möchte ich darauf hinweise, dass nicht nur (lautsprachliche) Kommunikation von Ambiguität betroffen ist, wie wir etwa von Kippbildern wissen. Die folgende Abbildung zeigt etwa ein Kippbild aus Joseph Jastrows Aufsatz The minds eye. Einerseits kann man darin eine Ente sehen oder auch einen Hasen. Diese Illusion würde allerdings verschwinden, würde man den Kopf der Ente auf einen Entenkörper montieren und in einen See neben andere Enten setzen würde. Genauso würde man keine Ente mehr sehen, würde man den Hasenkopf auf einen Hasenkörper setzen und auf einer Wiese neben anderen Hasen plazieren.

Jastrows „duck-rabbit illusion“

(http://en.wikipedia.org/wiki/File:Duck-Rabbit_illusion.jpg)

Da es sich bei Sätzen nicht um einzelne Zeichen handelt, die uns jeden Tag begegnen, können wir deren exakte Bedeutung nicht kennen. Und das müssen wir auch nicht, denn Sätze tauchen in natürlichen Sprachen so gut wie nie ohne Kontext auf (im Gegensatz zu den meisten linguistischen Beispielsätzen!). Es ist nur schwer vorstellbar, dass jemand auf der Straße zu ihnen kommt und ihnen mitteilt, dass John ein Kind hat. Handelt es sich dagegen um ein tatsächliches Gespräch dann gibt es in diesem Fall mehrere Möglichkeiten: John ist der Vater eines Kindes (Sohn oder Tochter) oder John betreut ein Kind (Junge oder Mädchen). Wir müssen aber davon ausgehen, dass ein common ground (Stalnaker 1974), also ein Wissen besteht, von dem die Sprecherin ausgeht, dass es die Hörerin besitzt. Und nur aufgrund dieses common ground wird sie eine Äußerung machen. Ein Missverständnis entsteht diesen Überlegungen zufolge also nicht daraus, dass der von ihr geäußerte Satz ambig ist, sondern daraus, dass sie eine falsche Annahme macht und die Hörerin eine Rückfrage stellen muss.

Dass es sich bei der „Debatte über Jugendkriminalität im Bundestag“, die die Frankfurter Allgemeine Zeitung am 17.01.2008 bespricht nicht um Jugendliche geht, die im Bundestag kriminell sind, ergibt sich aus unserem Weltwissen. Auch der vielziterte Satz I saw the man with the binoculars ist nur in Isolation ambig. Oder anders gesagt: Der Hauptquell der Ambiguität in natürlichen Sprachen ist Dekontextualisierung. Und genau das ist der Grund, warum künstliche Sprachen (wie Programmiersprachen) nicht ambig sind: Sie haben keine Verknüpfung mit der uns umgebenden Welt und müssen dementsprechend nicht interpretiert werden.

Dass Sprachen dazu tendieren redundant zu sein, wie es Cohen anführt, sehe ich auch so. Dies auf Ausdrücke anzuwenden, die die gleiche Bedeutung haben, halte ich für schwierig. Gibt es tatsächlich so viele Wörter, die das gleiche bedeuten? Selbst bei den wenigen als prototypisch zu wertenden Beispielen wie Zündholz vs. Streichholz und Apfelsine vs. Orange werden, je nachdem welches Wort man verwendet, gewisse Unterschiede festzustellen sein (sagen Sie mal einem Österreicher, Sie hätten gerne eine Apfelsine). So würde ich z.B. von einem Zündholz sprechen, wenn ich eine Geschichte schreiben würde, die in einem alten Herrenhaus spielt, aber nicht, wenn ich auf der Straße jemanden um Feuer bitte. Und wenn ich eine Orange verkaufen wollte, würde ich sie als Apfelsine anpreisen. Dennoch handelt es sich um strikte Synonymie (beim Zündholzfall wohl um zwei Wörter aus unterschiedlichen Zeiten, beim Apfelsinenfall um einen regionalen Unterschied). Aber viele Fälle lassen sich nicht finden. Schon bei Zimmer vs. Gemach und erst recht bei Pferd vs. Klepper fällt auf, dass es deutliche Unterschiede in der Bedeutung (sei es stilistisch oder wertend) gibt und dies lässt sich sprachökonomisch gut erklären.

Literatur:

Cohen, Ariel (2006): Why Ambiguity. http://www.zas.gwz-berlin.de/fileadmin/material/40-60-puzzles-for-krifka/pdf/cohen.pdf, zuletzt eingesehen am 11.7.2011.

Jastrow, J. (1899): The mind’s eye. In: Popular Science Monthly, 54, S. 299-312.

Stalnaker, R. (1974): Pragmatic presuppositions. In: Munitz, M. K. & Unger, P. K. (Hrsg.): Semantics and philosophy. New York: New York Univeristy Press, S. 197-213.

Zum Problem der Ambiguität der Sprachen:

Die Sprache ist in ihrem Sein grundsätzlich ambig. Jede Äußerung ist der Versuch aus der Menge der zur Verfügung stehenden Elemente, die für sich und als Gesamtheit völlig bedeutungslos, also unendlich ambig sind, eine möglichst eindeutige Interpretationsmöglichkeit zu selektieren, um ein mentales Konzept zum Ausdruck zu bringen. Das ist genau das Problem, das sich die poststrukturalistische Philosophie im Sinne der Problematisierung des Verhältnisses zwischen Signifikat und Signifikanten stellt. Jene Lücke, die sich an dieser Stelle auftut, kommt auch in linguistischen Beispielsätzen zum Vorschein. Indem man versucht, einzelne Sätze möglichst auf ihre Signifikanten zu reduzieren, also so wenig Bedeutung wie möglich zuzulassen, wird der Abstand zum Signifikat wieder um so größer. Es gibt keine ambige Kraft in der Sprache, vielmehr ist Sprache in ihrem Sein völlige Ambiguität und jede Äußerung nur der Versuch der Reduktion jener Ambiguität in Bezug auf den gerade aktualisierten Diskurs, also den Kontext. Jede Äußerung bleibt allerdings in dem Sinne ambig, dass die mentalen Konzepte verschiedener Bewusstseine nie völlig in Deckung gebracht werden können.

Zu Programmiersprachen:

Auch Code kann in gewisser Weise Ambiguität aufweisen. Wenn die Menge an geschriebenem Code groß genug ist, kann selbst die Programmiererin selbst nicht mehr überblicken, was für Wechselwirkungen sich zwischen einzelnen Teilen ergeben. Sie kann die Wirkungen nicht mehr konkret vorhersagen, weil der Code nicht mehr eindeutig interpretierbar ist. Für sich genommen ist zwar jede einzelne, isolierte Zeile einer eindeutigen Möglichkeit der Ausführung zugeordnet, in der Gesamtheit geht diese Eindeutigkeit jedoch verloren (insofern gilt auch hier Cohens Verweis auf die Komplexität von Sprachen).